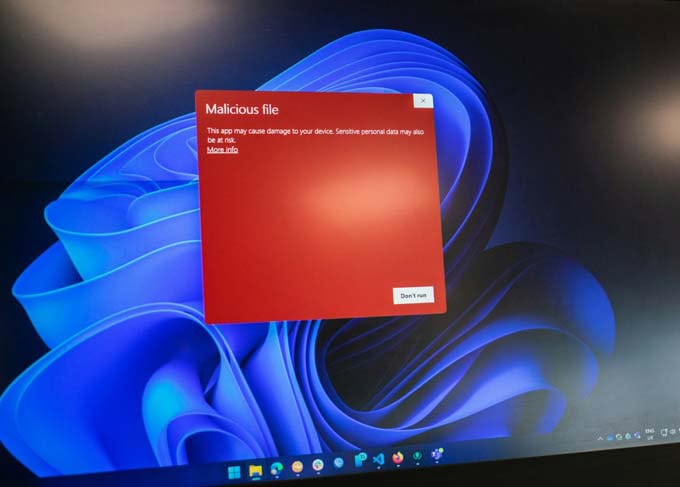

Les violations de la politique de données avec l'IA générative ont doublé

Le nouveau rapport Netskope Cloud & Threat 2026 pour la région DACH met en garde : alors que l'utilisation de l'IA générative (GenAI) est multipliée par trois, la sécurité des données est à la traîne. Les «risques hérités» tels que le phishing et les menaces internes restent critiques.

Malgré la tentative de contrôler l'utilisation de l'IA par le biais d'outils officiels d'entreprise, le récent rapport de l'OCDE sur l'IA montre que l'IA n'est pas un outil de gestion de la sécurité. Rapport sur le cloud et les menaces 2026 de Netskope Threat Labs, une évolution inquiétante : le nombre de violations de la politique de sécurité des données liées aux applications d'IA a plus que doublé par rapport à l'année précédente. Ainsi, le risque lié à l'IA fantôme reste élevé, les employés continuant à injecter massivement des données sensibles dans des canaux non protégés. Le rapport Netskope Cloud and Threat 2026 se base sur des données anonymisées collectées dans le monde entier via la plateforme Netskope Security Cloud. Il analyse les tendances de l'utilisation du cloud, de l'adoption de l'IA et du paysage mondial des menaces.

Le boom de l'IA prend le pas sur les mesures de sécurité

Le rapport montre une croissance explosive. Alors que le nombre d'utilisateurs d'applications GenAI SaaS a triplé l'année dernière, l'intensité de l'utilisation a augmenté de manière spectaculaire. Ainsi, le nombre d'invites envoyées a été multiplié par six. Un point particulièrement critique : malgré les efforts accrus des départements informatiques, 47 % des utilisateurs continuent d'utiliser des comptes d'IA privés à des fins professionnelles. En raison de cette IA fantôme, les entreprises enregistrent en moyenne 223 incidents par mois au cours desquels des données sensibles ont été envoyées à des applications d'IA. Pour le quart supérieur (25 %) des entreprises étudiées, ce chiffre dépasse même 2100 incidents par mois.

Parmi les autres résultats pertinents, le rapport indique

- Gemini est sur la voie de dépassement : Google Gemini a enregistré une croissance massive. Le taux d'utilisation est ainsi passé de 46 % à 69 %. Netskope prévoit que Gemini remplacera ChatGPT en tant que plateforme d'IA la plus utilisée dans les entreprises au cours du premier semestre 2026.

- Des fuites de données dangereuses : Le code source (42 %), les données réglementées (32 %) et la propriété intellectuelle (16 %) sont les informations sensibles les plus souvent téléchargées dans les outils d'IA.

- Risque d'initié «Apps personnelles 60 % de toutes les menaces internes sont liées à l'utilisation d'instances de cloud privé (comme Google Drive ou OneDrive), l'utilisation d'outils GenAI renforçant massivement ce risque. Plus inquiétant encore : 54 % des violations de la politique des données concernent des données réglementées (financières, de santé ou personnelles).

Agentic AI et MCP

Pour l'année 2026, Netskope met en garde contre la complexité croissante de l'IA agentique. Il s'agit de systèmes d'IA qui exécutent de manière autonome des tâches complexes sur différentes ressources de l'entreprise. «Agentic AI crée une toute nouvelle surface d'attaque», explique Ray Canzanese, directeur de Netskope Threat Labs. «Lorsque des agents autonomes ont accès à des données internes, des configurations erronées ou des invites malveillantes peuvent entraîner des fuites de données massives en quelques millisecondes». La tendance aux navigateurs contrôlés par l'IA et au Model Context Protocol (MCP) est également considérée comme un risque de sécurité critique pour 2026.

Recommandations pour l'action

Le rapport recommande aux entreprises d'adopter une protection à quatre niveaux :

- Inspection complète : Examen de l'ensemble du trafic HTTP/HTTPS, y compris le trafic de l'IA.

- Gouvernance des applications : Blocage des outils à haut risque sans but commercial (par exemple ZeroGPT, DeepSeek).

- Mise au point DLP : Utilisation de la prévention des pertes de données pour protéger le code source et les mots de passe de la fuite vers les modèles d'IA.

- l'isolement : Utilisation de l'isolation du navigateur à distance (RBI) pour les domaines à risque ou nouveaux.

Source : Netskope