IA embarquée : l'intelligence artificielle pour des décisions décentralisées en périphérie de réseau

L'IA embarquée déplace l'intelligence artificielle du cloud directement vers les appareils en périphérie du réseau. Cette évolution est stimulée par un matériel à faible consommation d'énergie, un traitement local des données et une prise de décision en temps réel. Les techniques avancées de compression et d'optimisation deviennent de plus en plus indispensables dans ce contexte.

L'IA embarquée devient de plus en plus un moteur central des systèmes de périphérie modernes. Grâce à cette technologie, l'intelligence artificielle se déplace du cloud directement là où elle est nécessaire - sur les appareils en périphérie du réseau. Le matériel embarqué à faible consommation d'énergie permet de réaliser des économies de coûts et d'énergie. Le traitement local protège les données et permet un fonctionnement hors ligne, tandis que l'IA en périphérie favorise la prise de décision en temps réel avec une latence minimale. Cela est nécessaire pour les systèmes autonomes et l'automatisation industrielle.

Un marché en pleine croissance grâce à un matériel spécialisé

Le marché de l'IA embarquée connaît une croissance rapide, portée par des composants matériels spécialisés comme les unités de traitement neuronal (NPU) et des architectures hétérogènes qui sont de plus en plus souvent intégrées directement dans des microcontrôleurs et des systèmes sur puce (SoC). Les ingénieurs sont ainsi confrontés au défi d'utiliser des modèles complexes sur des appareils disposant de ressources limitées en termes de mémoire et de calcul. Des techniques telles que la quantification, le pruning et d'autres méthodes de compression de modèles sont donc essentielles. Outre le matériel, des bibliothèques et des outils performants prennent de plus en plus d'importance pour rendre l'IA utilisable de manière fiable sur différentes plates-formes.

Un exemple concret de cette tendance est la combinaison de la reconnaissance des mots de réveil avec la reconnaissance et le suivi des objets sur les plates-formes Snapdragon de Qualcomm. Des réseaux basés sur YOLOX sont utilisés pour la reconnaissance d'objets, l'inférence étant transférée sur le NPU Hexagon. La NPU n'est activée qu'en cas de besoin, si un mot de réveil correspondant (signal audio) a été donné auparavant et que celui-ci a été reconnu par une deuxième NPU moins gourmande en énergie. Cette approche montre comment des architectures hétérogènes combinant une NPU à faible consommation d'énergie et un DSP hexagonal permettent de réaliser des tâches de traitement d'images en temps réel tout en maintenant l'efficacité énergétique.

Shift Left pour une IA intelligente

Avec la complexité croissante de l'IA embarquée, le besoin de processus de flux de travail clairement structurés augmente également. Le Model-Based Design offre un cadre pour cela : Au lieu d'écrire du code de bas niveau, les ingénieurs modélisent visuellement leurs algorithmes dans Simulink. Les exigences, les modèles et les artefacts de test sont ainsi réunis dans un fil d'actualité numérique unique, ce qui favorise la collaboration et la traçabilité tout au long du cycle de vie du produit.

L'un des principaux avantages de cette approche réside dans la validation précoce. Les tests Hardware-in-the-Loop (HIL) et Processor-in-the-Loop (PIL) permettent de détecter les problèmes potentiels à un stade précoce et d'accélérer le développement, conformément au principe «Shift Left». Le fonctionnement de cette approche peut être expliqué à l'aide d'un exemple tiré du secteur automobile. Dans le cadre de la planification et de la commande de trajectoires basées sur l'IA sur Infineon AURIX TC4x, les commandes de réseaux neuronaux sont conçues et validées avant leur utilisation à l'aide du Model-Based Design. En utilisant une unité de traitement parallèle (PPU) sur le matériel, cette solution permet d'obtenir une précision supérieure de 50 % et des économies d'énergie de 5 % par rapport aux approches traditionnelles - un exemple de la manière dont les flux de travail structurés et l'optimisation consciente du matériel offrent des avantages tangibles.

De Matlab au microcontrôleur

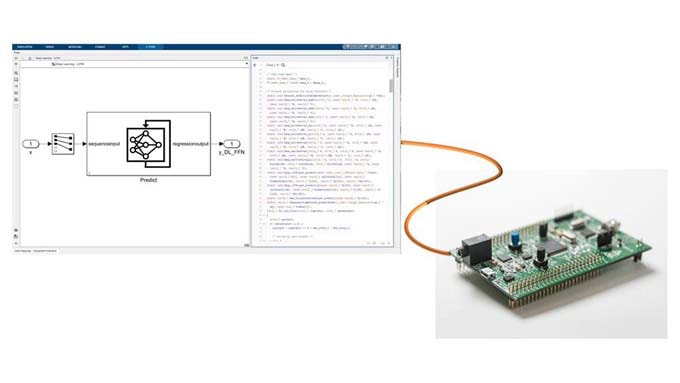

MathWorks offre un environnement intégré pour le développement et le déploiement de l'IA sur des systèmes embarqués. Les ingénieurs peuvent concevoir et entraîner leurs modèles dans Matlab ou importer des modèles déjà entraînés à partir de frameworks tels que PyTorch, TensorFlow et ONNX. À l'aide d'outils de génération automatique de code comme Matlab Coder et GPU Coder, ces modèles peuvent être traduits en code C, C++, CUDA ou HDL optimisé pour les CPU, GPU, FPGA et MCU. De cette manière, l'écart entre la conception de haut niveau et l'implémentation matérielle est comblé.

En outre, des flux de travail d'optimisation pour la quantification, le pruning et la compression sont intégrés dans la chaîne d'outils. Ils permettent une utilisation sur des appareils aux ressources limitées sans que les performances en soient affectées. En complément, des outils de vérification comme Polyspace assurent une fiabilité supplémentaire en analysant le code généré de manière statique et dynamique, en détectant les erreurs à un stade précoce du cycle de développement - ou en prouvant leur absence. Ces fonctions sont particulièrement importantes dans les domaines où la sécurité est critique, afin de garantir la conformité et la robustesse.

Un exemple pratique de ce flux de travail est la prédiction de la température des moteurs électriques sur le matériel TI C2000. Pour cela, des modèles de capteurs virtuels sont développés et entraînés dans Matlab ou Python, comprimés pour l'utilisation et validés à l'aide de tests Processor-in-the-Loop. Cette approche remplace les capteurs physiques par des fonctions d'estimation basées sur le logiciel, ce qui réduit les coûts et la complexité tout en conservant, voire en augmentant, la précision.

Utilisation dans de nombreux domaines d'application

L'IA embarquée est déjà utilisée dans de nombreux domaines d'application : dans le secteur de la santé, elle est par exemple utilisée pour le traitement du signal en temps réel dans l'analyse de l'ECG sur des cartes STM32. Des algorithmes d'apprentissage en profondeur et de traitement du signal sont combinés à cet effet. Les données des capteurs peuvent être traitées en temps réel à l'aide de la génération automatique de code C/C++. Les solutions d'IA embarquées sont également utilisées dans le domaine de la sécurité au travail : la reconnaissance des équipements de protection individuelle sur Raspberry Pi et la reconnaissance des poses sur les plateformes Nvidia Jetson montrent comment le traitement d'image embarqué et l'accélération GPU permettent de créer des solutions d'IA compactes et puissantes pour la surveillance et la conformité.

Les exemples cités illustrent une tendance plus large : l'IA embarquée n'est plus une technologie de niche, mais devient un standard pour les systèmes intelligents dans différents secteurs. Grâce à des flux de travail structurés et à l'utilisation de chaînes d'outils intégrées, les ingénieurs peuvent accélérer leurs processus de développement, garantir leur fiabilité et optimiser les performances pour les déploiements en périphérie. À mesure que l'IA générative et les flux de travail avancés se rapprochent de la périphérie, des méthodes efficaces et une optimisation tenant compte du matériel seront la clé pour en exploiter pleinement le potentiel.

MathWorks présentera aux ingénieurs et aux développeurs, lors du salon embedded world qui se tiendra à Nuremberg du 10 au 12 mars 2026 (hall 4, stand 110), une série de conférences spécialisées sur différents thèmes et scénarios d'application. Sur le stand, les visiteurs auront un aperçu de différentes démonstrations, dont la planification de trajectoires basée sur l'IA sur Infineon AURIX TC4x, le suivi d'objets sur Qualcomm Snapdragon, le calcul de température basé sur l'IA pour les moteurs électriques ainsi que le traitement de signaux en temps réel sur les appareils IoT.