L'IA privata come risposta ai requisiti più severi in materia di protezione dei dati

In occasione del Safer Internet Day 2026, l'attenzione si sposta sull'uso responsabile dell'intelligenza artificiale. Se da un lato la situazione delle minacce è peggiorata di oltre il 56% secondo lo Stanford AI Index Report, dall'altro le aziende devono rispettare il GDPR e l'EU AI Act. L'intelligenza artificiale privata offre una soluzione in cui i dati sensibili non lasciano mai l'ambiente aziendale.

La discussione sul Safer Internet Day è cambiata radicalmente negli ultimi anni. Invece dell'igiene delle singole password, nel 2026 l'attenzione si concentrerà su temi più ampi come la regolamentazione dell'intelligenza artificiale. In Germania, il GDPR e la legge UE sull'intelligenza artificiale stanno rendendo più severi i requisiti per la gestione dei sistemi di intelligenza artificiale. Allo stesso tempo, le aziende stanno cercando di tenere il passo con i progressi dell'IA e di diventare sempre più orientate ai dati.

I dati costituiscono la base per l'utilizzo dell'IA, soprattutto quando le aziende dispongono di grandi quantità di informazioni sui consumatori. Secondo un'indagine di Cloudera, ciò si riflette nella cultura dei dati: in Germania, la percentuale di intervistati che classificano la propria cultura aziendale come «estremamente orientata ai dati» è passata dall'otto per cento (2024) al 30 per cento (2025).

Situazione di minaccia volatile e tensioni geopolitiche

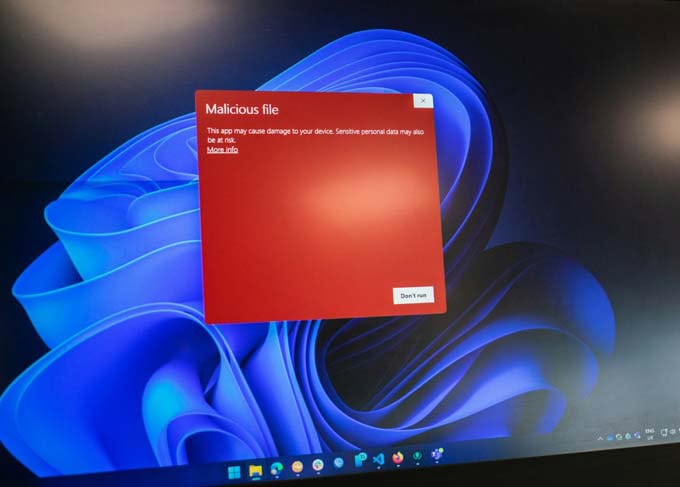

L'urgenza di considerare la protezione dei dati come parte delle strategie di IA deriva da una situazione di minaccia volatile e da tensioni geopolitiche. Il crescente utilizzo dell'IA in varie aree aziendali aumenta la superficie di attacco per le minacce informatiche. Lo Stanford AI Index Report 2025 documenta un aumento degli incidenti di sicurezza e protezione dei dati nell'ambiente dell'IA di oltre il 56% in un anno.

I dati dei consumatori continuano a essere oggetto di particolare attenzione da parte dei criminali informatici: Nel rapporto Cost of a Data Breach di IBM, sono stati il tipo di dati più comunemente compromessi a livello globale, comparendo nel 53% di tutte le violazioni di dati del settore retail. Le crescenti minacce informatiche prendono di mira i grandi volumi di transazioni e i dati personali sensibili gestiti dai rivenditori e dalle istituzioni finanziarie.

Inoltre, la consapevolezza dei consumatori sul valore dei loro dati è aumentata, come dimostra il Data Privacy Benchmark Study di Cisco 2026. Secondo lo studio, il 46% delle aziende globali dichiara che una comunicazione chiara su come l'IA viene addestrata con i dati dei consumatori è essenziale. Questo è l'unico modo per mantenere la fiducia degli utenti in un'organizzazione.

L'IA privata supera il dilemma della protezione dei dati

Le aziende devono gestire e proteggere responsabilmente i dati che guidano la loro crescita per ridurre il rischio di fughe di dati e di accessi non autorizzati. In queste circostanze, una singola violazione non solo porta a multe, ma può anche danneggiare la reputazione e il valore del marchio a lungo termine. Allo stesso tempo, è importante esplorare i limiti dell'IA per ottenere un vantaggio competitivo.

L'IA privata è emersa come una struttura chiave per le aziende moderne. Si tratta di un approccio strategico che definisce il modo in cui le aziende sviluppano, operano e gestiscono i sistemi di IA. L'IA privata garantisce che i dati di input e output dei modelli non lascino mai l'ambiente aziendale. Tutte le informazioni rimangono all'interno dell'infrastruttura aziendale. Ciò consente alle aziende di superare il «dilemma della protezione dei dati». L'IA privata smentisce l'ipotesi che le aziende debbano scegliere tra utilizzare i dati per l'innovazione e bloccarli per l'IA per motivi di conformità.

La visibilità assoluta come prerequisito

Tuttavia, un'AI efficace e privata richiede un'assoluta visibilità dei dati. Secondo il rapporto di Gartner sulla gestione dei metadati, quasi il 60% delle aziende ammette di non sapere dove si trovano i propri dati critici. E ciò che non si vede, non si può controllare. Per ovviare a questo problema, le aziende di successo oggi utilizzano piattaforme di dati standardizzate, come quelle di Cloudera, che offrono una perfetta tracciabilità dei dati. Tracciano esattamente da dove provengono i dati, come sono stati trasformati e chi vi ha avuto accesso.

Poiché gli agenti di IA generativa diventano sempre più parte integrante dei flussi di lavoro, i dati che vengono loro forniti devono essere attentamente esaminati. I dati più preziosi per la messa a punto dell'IA - le trascrizioni dell'assistenza e le cronologie delle transazioni - sono spesso anche tra le informazioni più sensibili. La protezione e la sicurezza dei dati possono quindi diventare un fattore di valore decisivo. In un periodo di crescente regolamentazione e incertezza geopolitica, le aziende che avranno successo saranno quelle che implementeranno proattivamente misure di protezione e garantiranno che la loro IA sia privata, controllata e sicura fin dall'inizio.

Più informazioni: www.cloudera.com