Embedded AI: intelligenza artificiale per decisioni decentralizzate ai margini della rete

L'intelligenza artificiale integrata sta spostando l'intelligenza artificiale dal cloud direttamente ai dispositivi ai margini della rete. Questo sviluppo è guidato da hardware a risparmio energetico, elaborazione locale dei dati e processo decisionale in tempo reale. Le tecniche avanzate di compressione e ottimizzazione stanno diventando sempre più indispensabili.

L'intelligenza artificiale integrata sta diventando sempre più un elemento centrale dei moderni sistemi edge. Con questa tecnologia, l'intelligenza artificiale si sta spostando dal cloud direttamente dove è necessaria: ai dispositivi ai margini della rete. L'hardware incorporato a basso consumo energetico garantisce un risparmio di costi e di energia. L'elaborazione locale protegge i dati e consente il funzionamento offline, mentre l'intelligenza artificiale ai margini della rete supporta il processo decisionale in tempo reale con una latenza minima. Tutto ciò è necessario per i sistemi autonomi e l'automazione industriale.

Mercato in rapida crescita grazie all'hardware specializzato

Il mercato dell'intelligenza artificiale incorporata è in rapida crescita, grazie a componenti hardware specializzati come le unità di elaborazione neurale (NPU) e le architetture eterogenee che vengono sempre più spesso integrate direttamente nei microcontrollori e nei sistemi su chip (SoC). Questo pone agli ingegneri la sfida di implementare modelli complessi su dispositivi con memoria e risorse di calcolo limitate. Tecniche come la quantizzazione, il pruning e altri metodi di compressione dei modelli sono quindi essenziali. Oltre all'hardware, librerie e strumenti potenti stanno diventando sempre più importanti per rendere l'IA utilizzabile in modo affidabile su piattaforme diverse.

Un esempio concreto di questa tendenza è la combinazione del riconoscimento delle parole sveglia con il riconoscimento e il tracciamento degli oggetti sulle piattaforme Qualcomm Snapdragon. Per il riconoscimento degli oggetti vengono utilizzate reti basate su YOLOX, mentre l'inferenza è affidata alla NPU Hexagon. La NPU viene attivata solo se in precedenza è stata emessa una parola d'ordine corrispondente (segnale audio), riconosciuta da una seconda NPU più efficiente dal punto di vista energetico. Questo approccio mostra come le architetture eterogenee che combinano una NPU a basso consumo con un DSP Hexagon permettano di svolgere attività di elaborazione delle immagini in tempo reale mantenendo l'efficienza energetica.

Spostamento a sinistra per un'intelligenza artificiale intelligente

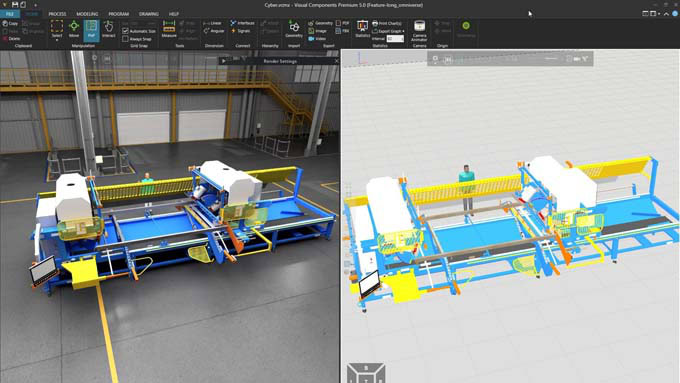

Con l'aumento della complessità dell'intelligenza artificiale incorporata, aumenta anche la necessità di processi di flusso di lavoro chiaramente strutturati. La progettazione basata su modelli fornisce un quadro di riferimento per questo: Invece di scrivere codice di basso livello, gli ingegneri modellano visivamente i loro algoritmi in Simulink. Requisiti, modelli e artefatti di test vengono riuniti in un filo digitale standardizzato, che supporta la collaborazione e la tracciabilità durante l'intero ciclo di vita del prodotto.

Un vantaggio fondamentale di questo approccio è la validazione precoce. Con l'aiuto dei test hardware-in-the-loop (HIL) e processor-in-the-loop (PIL), è possibile riconoscere i potenziali problemi in una fase iniziale e accelerare lo sviluppo, in linea con il principio dello «shift left». Il funzionamento di questo approccio può essere spiegato con un esempio tratto dall'industria automobilistica. Nella pianificazione e nel controllo della traiettoria basati sull'intelligenza artificiale su Infineon AURIX TC4x, i controllori a rete neurale vengono progettati e convalidati utilizzando la progettazione basata su modelli prima dell'implementazione. Utilizzando un'unità di elaborazione parallela (PPU) sull'hardware, questa soluzione raggiunge un'accuratezza superiore del 50% e un risparmio energetico del 5% rispetto agli approcci convenzionali: un esempio di come i flussi di lavoro strutturati e l'ottimizzazione consapevole dell'hardware producano vantaggi tangibili.

Da Matlab al microcontrollore

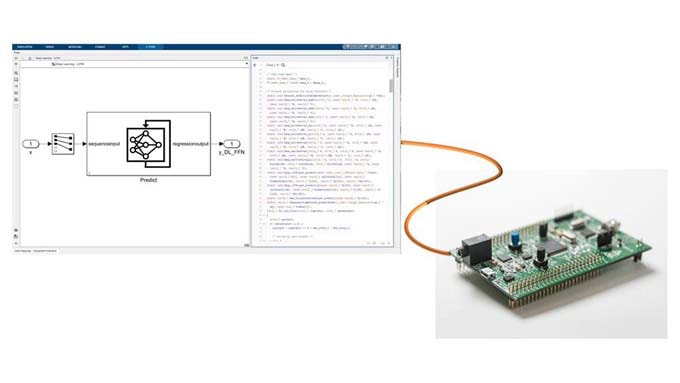

MathWorks offre un ambiente integrato per lo sviluppo e l'implementazione dell'intelligenza artificiale sui sistemi embedded. Gli ingegneri possono progettare e addestrare i propri modelli in Matlab o importare modelli pre-addestrati da framework come PyTorch, TensorFlow e ONNX. Con l'aiuto di strumenti di generazione automatica del codice come Matlab Coder e GPU Coder, questi modelli possono essere tradotti in codice C, C++, CUDA o HDL ottimizzato per CPU, GPU, FPGA e MCU. In questo modo si colma il divario tra la progettazione di alto livello e l'implementazione hardware.

I flussi di lavoro di ottimizzazione per la quantizzazione, la potatura e la compressione sono integrati nella catena di strumenti. Essi consentono l'utilizzo su dispositivi con risorse limitate senza compromettere le prestazioni. Inoltre, strumenti di verifica come Polyspace garantiscono un'ulteriore affidabilità analizzando il codice generato in modo statico e dinamico, rilevando gli errori nelle prime fasi del ciclo di sviluppo o dimostrandone l'assenza. Queste funzioni sono particolarmente importanti nelle aree critiche per la sicurezza, per garantire la conformità e la robustezza.

Un esempio pratico di questo flusso di lavoro è la previsione della temperatura dei motori elettrici su hardware TI C2000. I modelli di sensori virtuali vengono sviluppati e addestrati in Matlab o Python, compressi per l'uso e convalidati mediante test in loop del processore. Questo approccio sostituisce i sensori fisici con funzioni di stima basate su software, riducendo i costi e la complessità e mantenendo o addirittura aumentando la precisione.

Utilizzo in numerose aree di applicazione

L'intelligenza artificiale incorporata viene già utilizzata in numerosi settori di applicazione: nel settore sanitario, ad esempio, viene impiegata per l'elaborazione del segnale in tempo reale nell'analisi dell'ECG su schede STM32. Qui si combinano algoritmi di deep learning e di elaborazione del segnale. I dati dei sensori possono essere elaborati in tempo reale con l'aiuto della generazione automatica di codice C/C++. Le soluzioni AI integrate sono utilizzate anche nel campo della sicurezza sul lavoro: il riconoscimento dei dispositivi di protezione individuale su Raspberry Pi e il riconoscimento della posa su piattaforme Nvidia Jetson mostrano come l'elaborazione delle immagini e l'accelerazione GPU integrate consentano soluzioni AI compatte e potenti per il monitoraggio e la conformità.

Questi esempi sono indicativi di una tendenza più ampia: l'intelligenza artificiale incorporata non è più una tecnologia di nicchia, ma sta diventando uno standard per i sistemi intelligenti in vari settori. Grazie a flussi di lavoro strutturati e all'uso di toolchain integrati, gli ingegneri possono accelerare i processi di sviluppo, garantire l'affidabilità e ottimizzare le prestazioni per le implementazioni edge. Mentre l'intelligenza artificiale generativa e i flussi di lavoro avanzati si avvicinano sempre di più all'edge, i metodi efficienti e l'ottimizzazione dell'hardware saranno la chiave per realizzare il loro pieno potenziale.

MathWorks presenterà diversi argomenti chiave e scenari applicativi a ingegneri e sviluppatori in occasione dell'Embedded World, che si terrà dal 10 al 12 marzo 2026 a Norimberga (Padiglione 4, Stand 110) in una serie di presentazioni specialistiche. I visitatori dello stand potranno approfondire diverse dimostrazioni, tra cui la pianificazione della traiettoria basata sull'intelligenza artificiale su Infineon AURIX TC4x, il tracciamento di oggetti su Qualcomm Snapdragon, il calcolo della temperatura basato sull'intelligenza artificiale per i motori elettrici e l'elaborazione del segnale in tempo reale sui dispositivi IoT.